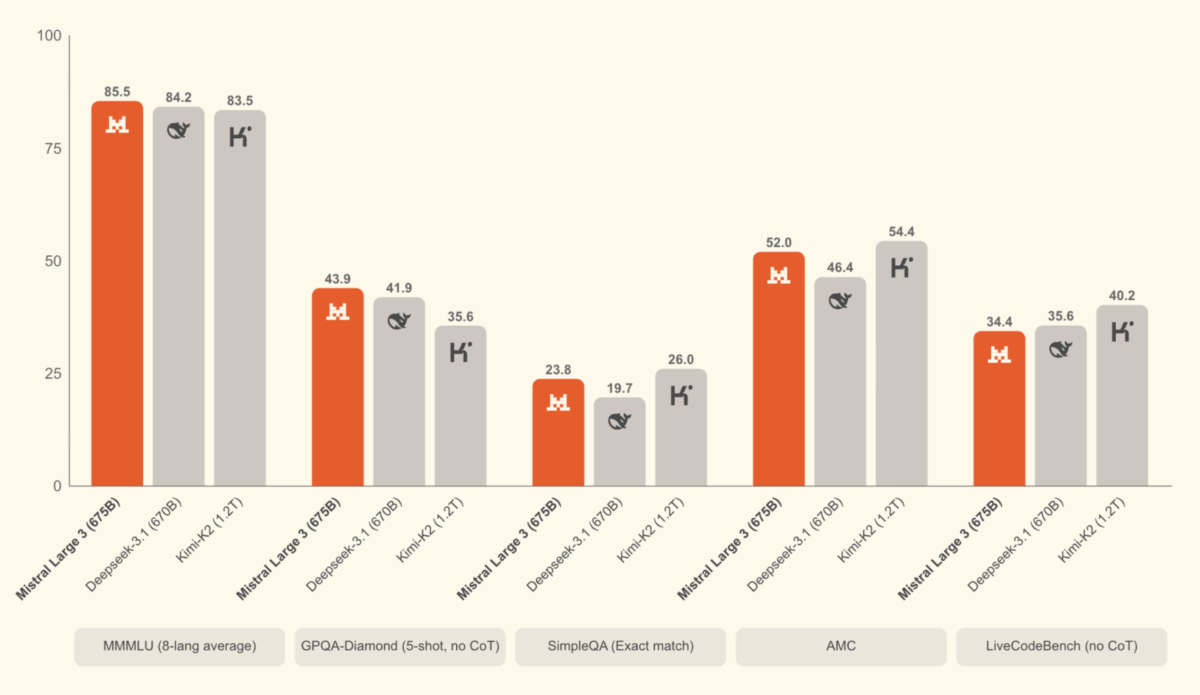

Wie zuverlässig ist das Wissen der KI-Modelle?

Ein interessanter Artikel über einen neuen Benchmark für KI-Modelle, der nicht nur das Wissen, sondern auch die Zuverlässigkeit bewertet. Die Ergebnisse zeigen, dass die Modelle der großen Anbieter in vier Kategorien eingeteilt werden können:

- Modelle mit viel Wissen und hoher Zuverlässigkeit, z.B. Cloude 4.1 Opus

- Modelle mit viel Wissen, aber niedriger Zuverlässigkeit, z.B. Claude 4.5 Haiku

- Modelle mit wenig Wissen, aber hoher Zuverlässigkeit, z.B. GPT 5.1

- Modelle mit wenig Wissen und niedriger Zuverlässigkeit (z.B. das kleine Open-Source-Modell von OpenAI, gtp-oss)

Die Modelle wurden mit 6000 Fragen aus den Bereichen Business, Geisteswissenschaften, Sozialwissenschaften, Gesundheit, Recht, Software Engineering sowie Naturwissenschaften und Mathematik getestet. 10% davon wurden veröffentlicht, der Rest bleibt unter Verschluss, damit die Modelle nicht gezielt auf den Benchmark trainiert werden können.

Comments ()